机器内容产出火爆出圈,但是否符合人类价值观就是其核心问题

ChatGPT突然的火爆出圈,让智能内容产出成了一种可能。可是我们在接受着这样一种现状的同时,也需要审视这一现状背后更深层次的问题。

比如,ChatGPT提供的内容并不一定完全符合我们人类的习惯,甚至也有很多内容,存在着巨大的误解和偏见,对于我们中国读者人来说,用ChatGPT可以看到很多奇奇怪怪的答案,一看就能够了解它背后的价值观,有经验的人也能够一眼看到这些内容来自于人工智能,和真人创作是有差别的。

为什么会这样呢?其实智能内容产出依然需要的是机器学习,但机器学习本身就有着非常多不确定性,有着很多依然需要我们解决的问题。

机器学习并不是一种完全自主的学习,和我们人类的学习方式也有着本质的差别,它依然是基于大量信息的基础上,依靠算法来完成。

这其中有着两个关键词,分别是信息和算法,但人工智能的信息和算法也依然是人为操控的,因为人为操控所属的不同文化氛围和个人喜好,所选择的不同信息、不同算法,也就让机器学习有了完全不同的表现形式,也就会有偏见。

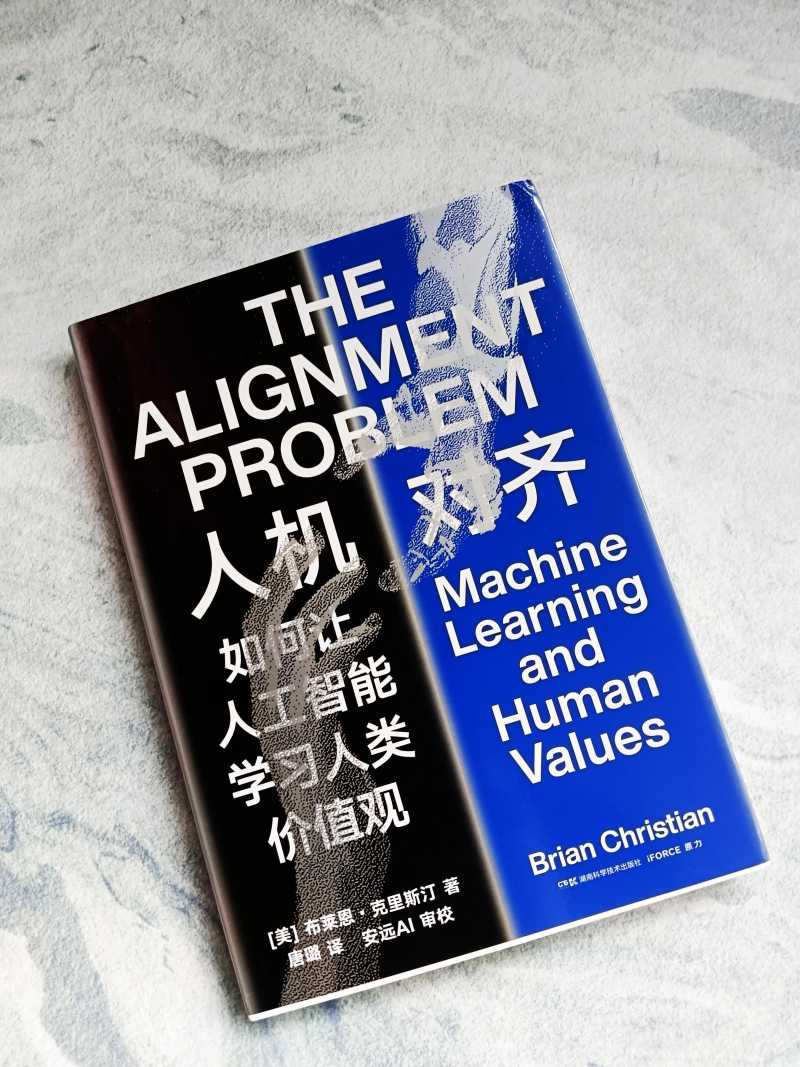

布莱恩·克里斯汀,畅销书作家,他的《算法之美》入选了亚马逊年度最佳科学书籍和MIT技术评论年度书籍;《人机大战》也是畅销书,这都是他关注于人与机械之间的相互关系而产生的思考。

现在他相应的思考依然在继续,因此也就创作了这样一本《人机对齐:如何让人工智能学习人类价值观》,关注于人工思考的最后阵地,机器学习和人类价值观之间的相应匹配,也就被作者形象的称为“人机对齐”问题。

其实这也是基于现实之中人工智能所表现出来的价值观偏见得出来的结论。偏见肯定是人与机器共有,而我们人类的价值观受到道德制约,可以及时做出调整,但机器却无法做到,这就让这种价值观倾向在人工智能领域表现的更加重要,也更具风险。

基于机器学习的相关理论,怎样来改善这一缺陷,怎样完善机器学习最重要的一步呢?克里斯汀精练地描绘了机器学习的发展史,并且深入科研一线同科学家对话,准确呈现了机器学习前沿的进展,并给出很多切实可行的建议。

其实人机对齐问题,说到底依然是人类自身的问题,理应让我们人类在其中扮演重要的角色。就像作者所说“对其问题还是一面镜子,将人类自身的偏见和盲点暴露出来,让我们看清自己从未阐明的假设和经常自相矛盾的目标”。

那么在进行完善机器学习的同时,我们也需要不断的审视自身,只有我们自身能够有着广阔的人类视野,不带偏见的把信息和算法传递给机器,机器才能给出不带偏见的程序,而这是一个任重而道远的过程。人类的文化也在时刻的变更之中,但相信通过作者的这一系统性审视,一定能够让我们看到一条更为广阔的道路。#人机交互##人工智能##

大家都在看

-

这个冬天去哪玩?沈阳16条冬季游特色线路来啦! 玩雪、滑冰、看雪景美食、洗浴、赶大集……这个冬天在沈阳怎么玩你安排了吗?“冬日雪暖阳 ‘圈’出好风光”沈阳都市圈携手推出100条冬季特色旅游线路承包你的冬日快乐!沈阳市、鞍山市、抚顺市、本溪市、阜新市、辽 ... 机械之最12-20

-

财经聚焦·对话企业掌门人丨一根耐寒电缆的创新突围——对话欧耐特线缆董事长杨振涛 近日,欧耐特线缆集团有限公司自主研发的零下40℃耐寒特种电缆,成功中标某大型项目。位于青海西宁市的生产车间内,董事长杨振涛正带领生产团队敲定年后订单的排产细节。从销售代理公司成长为集研发、生产、销售于一 ... 机械之最12-20

-

新华鲜报丨驻华使节吉林行:点赞“冷资源”里的热活力! 新华社长春12月19日电 题:驻华使节吉林行:点赞“冷资源”里的热活力!新华社记者袁睿、姜明明白山松水裹银装,创新发展腾热浪。12月16日至18日,应外交部邀请,23位驻华大使、外交官及国际组织负责人走进吉林省长 ... 机械之最12-20

-

原机械工业部直属5所全国重点大学,如今怎么样了? 中华人民共和国机械工业部,简称:机械工业部、机工部。它是1952年开始组建的,前后共计分有7个部。1998年并入信息产业部, 之后又并入 工业和信息化部 。在它最辉煌的那些年中,直属高校曾达到了23所,其中不乏如今 ... 机械之最12-20

-

我为什么记住了冬至?“家里还有你阿嫲” 原标题:冬至在南方,冬天的到来总是显得珍稀。冬至有一年最长的夜,不单被称为冬节,地位还堪比过年。小时候老人会说“吃了冬节丸就大一岁”,让我以为冬至这一天的汤圆有什么加速时间的魔力,但其实不过是普通的糯 ... 机械之最12-20

-

智慧的巅峰:揭秘三国时期最神奇的机械发明——木牛流马 在中国历史的长河中,三国时期是一段充满英雄豪杰、谋略智慧的时代。其中,蜀汉丞相诸葛亮以其卓越的政治才能、军事谋略和忠诚精神,成为后世敬仰的楷模。而在诸葛亮众多的发明和谋略中,“木牛流马”无疑是最具代表 ... 机械之最12-20

-

仅一根手指一根脚趾能动,他却和母亲建起一座农场! 如果一个人全身瘫痪,卧病在床,靠呼吸机维持生命,仅有一根手指和一根脚趾能动,他还能做什么?在重庆两江新区木耳镇,进行性肌营养不良患者黎夏通过自学物理、化学、计算机编程、机械、农学、医学等知识,和母亲一 ... 机械之最12-19

-

新华网科技观察丨6G与AI融合会带来什么? 新华网北京12月18日电 题:6G与AI融合会带来什么?新华网记者凌纪伟6G与AI,并非两条并行的轨道。AI赋能6G创新,6G又将AI的触角延伸到各领域。两者融合、相互赋能,构筑起智能时代的数字底座。“十五五”规划建议提 ... 机械之最12-19

-

为世界荒漠化治理提供“中国范本”——探寻中国四大沙漠戴上“绿围脖”背后的故事 新华社北京12月18日电 《参考消息》近日刊发文章《为世界荒漠化治理提供“中国范本”——探寻中国四大沙漠戴上“绿围脖”背后的故事》。全文如下:这条人工生态屏障不仅有效遏制了沙尘南下东进的通道,也为世界干旱 ... 机械之最12-19

-

四川哪里的金子最多? 四川日报全媒体记者 王若晔又又又找到金子啦!12月18日,山东烟台消息,莱州市三山岛北部海域新发现国内唯一、亚洲最大的海底巨型金矿。不仅在山东,连月来,全国多地接连传来探“金金金金金”捷报:辽宁探明全国首 ... 机械之最12-19

相关文章

- 四川哪里的金子最多?

- 十几颗下肚,女子痛到直不起腰!医生查完惊呆:实在太大了!千万别这样吃!

- 钱塘江丨布的突围

- 无人机群飞行规划员、智慧仓运维员……科技催生令人心动新职业

- 中外交流丨镜头下的沙海新绿——从图片展上的照片看新疆带给世界的治沙灵感

- 中国玩具如何“玩转”全球大市场?

- 专科生逆袭!2026机械专业必考8大黄金证书,好就业薪资高!

- 高考志愿填报常识34:中国机械“五虎四小龙”

- 在寒风中飘落的树叶是麻烦还是资源?每年520万吨枯枝落叶去哪了

- 跃升48位!太重再次荣登“中国机械500强”榜单

- Anthropic重磅新研究:当AI采访了1250人,它看见了人类的“职业软肋”

- 废墟上,他们把日子重新拧上弦

- 世界五大军事家第5名:成吉思汗 —— 冷兵器时代最恐怖的战争机器

- “十四五”期间 太原市强化企业创新主体地位 激发创新活力

- 外骨骼机器人“出圈” 行业痛点待解

- 理科专业解读一:从学业到就业,一文搞懂机械类专业!

- 大专生逆袭!2026机械设计与制造专业必考8大证书

- 一级军士长的带兵“三字诀”

- 卖“陪伴”成了生意经?为什么大家都不想独处了

- 四大维度,深度解析2025年中国机械工业500强

热门阅读

-

天下第一暗器暴雨梨花针,传说中的唐门暗器做出来了 07-13

-

世界十大大型船舶排名,第一能承重六十万吨! 07-13