8个最流行的机器学习模型部署工具

我们如何在生产环境中创建和部署经过训练的模型 API 受到机器学习生命周期的许多方面的控制。 MLOps 的概念对于处理复杂的 ML 部署环境非常有益。

实施可靠的 MLOps 可以为投资机器学习的公司带来巨大收益。 了解要使用和执行什么是这个难题的重要组成部分。 学习和适应简化整个工作流程的新工具是另一回事。

本文列出了用于模型部署的最佳工具。 帮助你扩展和管理机器学习生命周期的所有要素,包括服务、监控和管理 API 端点。

推荐:用 NSDT编辑器 快速搭建可编程3D场景

1、Seldon.io

Seldon.io 提供 Seldon 核心,这是一个开源框架。 该框架简化并加速了 ML 模型部署。Seldon 处理和服务在任何其他开源 ML 框架中构建的模型。 ML 模型部署在 Kubernetes 中。 随着它与 Kubernetes 一起扩展,它使我们能够使用最先进的 Kubernetes 功能,例如自定义资源定义来处理模型图。

Seldon 还提供将项目与持续集成和部署 (CI/CD) 工具连接起来的功能,以扩展和更新模型部署。它有一个警报系统,可以在监控生产中的模型时出现问题时通知你。 可以定义模型来解释某些预测。 该工具可在云端和本地使用。

Seldon的优点:

定制离线模型。向外部客户端公开 API实时预测。简化部署过程。Seldon的缺点:

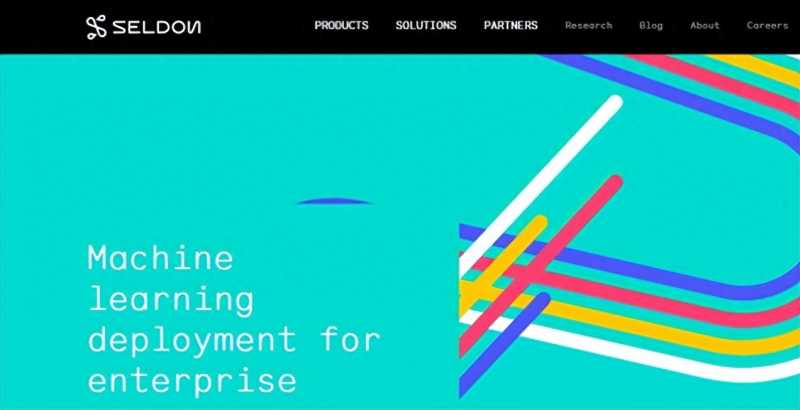

设置可能有点复杂。对于新人来说学习可能会很困难。2、BentoML

BentoML 简化了构建机器学习服务的过程。 它提供了一个基于 Python 的标准架构,用于部署和维护生产级 API。 该架构允许用户使用任何 ML 框架轻松打包经过训练的模型,以进行在线和离线模型服务。

BentoML 的高性能模型服务器支持自适应微批处理以及独立于业务逻辑扩展模型推理工作人员的能力。 UI 仪表板提供了一个集中式系统来组织模型和监控部署流程。

其模块化设计使得配置可与现有的 GitOps 工作流程重用,并且自动 docker 映像生成使部署到生产成为一个简单且版本化的过程。

多用途框架解决了 ML 模型的服务、组织和部署问题。 主要重点是将数据科学和 DevOps 部门连接起来,以提供更高效的工作环境并生成高性能的可扩展 API 端点。

BentoML 优点:

用于轻松大规模部署预测服务的实用格式支持以单一统一格式提供高性能模型服务和部署支持模型部署到多个平台,而不仅仅是 KubernetesBentoML 缺点:

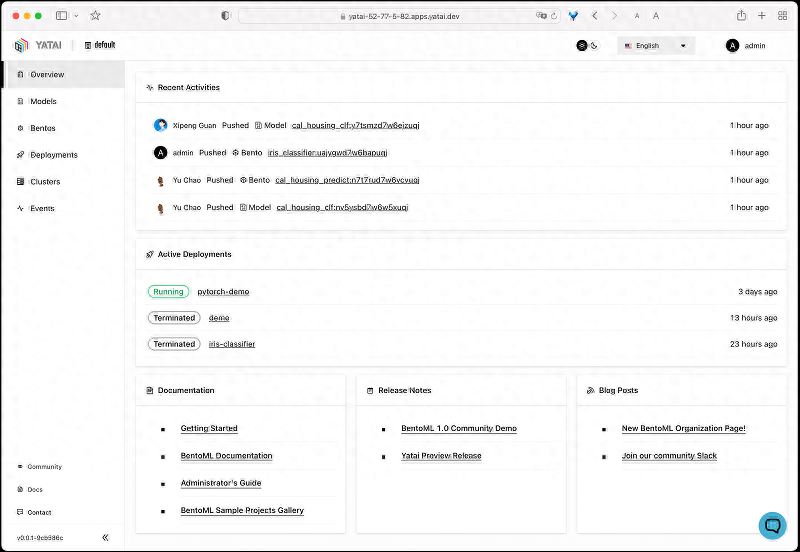

不专注于实验管理。不处理开箱即用的水平缩放。3、TensorFlow Serving

如果想将经过训练的模型部署为端点,可以使用 TensorFlow Serving 来实现。它允许您创建一个将为经过训练的模型提供服务的 REST API 端点。

TensorFlow Serving 是一个强大的高性能系统,用于为机器学习模型提供服务。你可以轻松部署最先进的机器学习算法,同时维护与其各自端点相同的服务器架构。 它功能强大,足以为不同类型的模型和数据以及 TensorFlow 模型提供服务。

它是由谷歌创建的,许多顶级公司都在使用它。 将模型作为集中模型库提供服务是一个很好的方法。 服务架构足够高效,足以让大量用户同时访问模型。

如果由于大量请求而出现阻塞,可以使用负载均衡器轻松维护。 总体而言,该系统具有良好的可扩展性、可维护性和高性能。

TensorFlow 服务的优点:

一旦部署模型准备就绪,该工具就可以轻松提供服务。它可以向同一模型发起批量请求,从而有效地利用硬件。它还提供模型版本管理。该工具易于使用,负责模型和服务管理。TensorFlow 服务的缺点:

当加载新模型或更新旧模型时,无法确保零停机。仅适用于 TensorFlow 模型。4、Kubeflow

Kubeflow 的主要目标是维护机器学习系统。 它是专为 Kubernetes 设计的强大套件。主要操作包括打包、组织docker容器,帮助维护整个机器学习系统。

Kubeflow简化了机器学习工作流程的开发和部署,从而使模型可追溯。 它提供了一组强大的 ML 工具和架构框架来高效执行各种 ML 任务。

多功能 UI 仪表板可以轻松管理和跟踪实验、任务和部署运行。 Notebook 功能使我们能够使用指定的平台开发套件与 ML 系统进行交互。

组件和管道是模块化的,可以重复使用以提供快速解决方案。 该平台由 Google 启动,旨在通过 Kubernetes 为 TensorFlow 任务提供服务。 后来它扩展到执行整个机器学习管道的多云、多架构框架。

Kubeflow 的优点:

一致的基础设施,提供监控、运行状况检查、每次复制以及新功能的扩展。简化新团队成员的入职流程。标准化流程有助于建立安全性并更好地控制基础设施。Kubeflow 的缺点:

很难手动设置和配置。高可用性不是自动的,需要手动配置。这个工具的学习曲线很陡。5、Cortex

Cortex 是一种开源多框架工具,足够灵活,可以用作模型服务工具,也可以用于模型监控等目的。

凭借其处理不同机器学习工作流程的能力,它使你能够完全控制模型管理操作。 它还可以作为使用 SageMaker 工具提供模型的替代方案,以及基于 AWS 服务(例如 Elastic Kubernetes Service (EKS)、Lambda 或 Fargate)的模型部署平台。

Cortex 扩展到 Docker、Kubernetes、TensorFlow Serving 和 TorchServe 等开源项目。 它可以与任何 ML 库或工具结合使用。 它提供端点的可扩展性来管理负载。

它允许你在单个 API 端点中部署多个模型。 它还充当在不停止服务器的情况下更新已生产端点的解决方案。 它涵盖了模型监控工具的足迹,监控端点的性能以及预测数据。

Cortex优点:

自动缩放功能可确保 API 在网络流量波动时保持安全。支持Keras、TensorFlow、Scikit-learn、PyTorch等多个平台。更新模型时无需停机。Cortex缺点:

设置过程可能有点令人畏惧。6、AWS Sagemaker

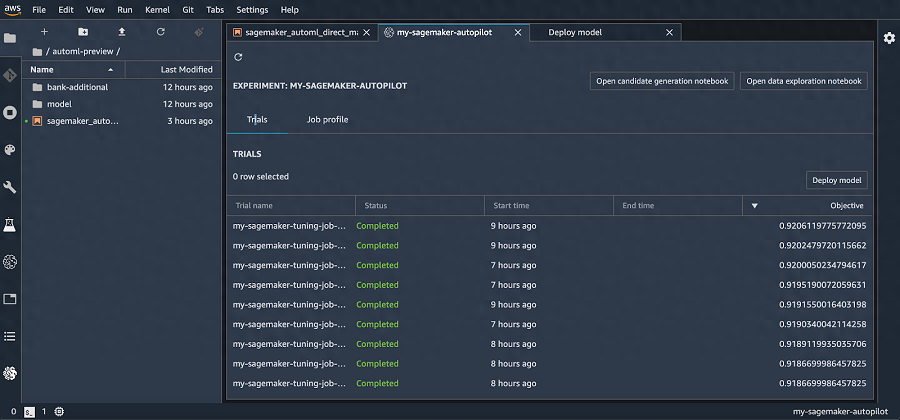

AWS Sagemaker 是 Amazon 提供的一项强大服务。 它使机器学习开发人员能够快速构建、训练和部署机器学习模型。

它通过删除一些复杂的步骤来简化整个机器学习过程,从而提供高度可扩展的机器学习模型。

机器学习开发生命周期是一个复杂的迭代过程。 它迫使你集成复杂的工具和工作流程。 这项任务可能要求很高且令人恼火,并且可能会消耗你大量的时间。 更不用说配置时出错的麻烦了。

Sagemaker 使这个过程变得更容易,在集中式工具集中提供用于机器学习的所有组件。 无需配置每一项,因为它已经安装并可供使用。

这可以以最小的工作量和成本加速模型的生产和部署。 该工具可用于使用任何机器学习框架创建的端点。 它还提供预测跟踪和捕获以及时间表监控。

AWS Sagemaker 的优点:

设置过程很简单,可以与 Jupyter Notebook 一起运行。 因此,简化了脚本的管理和部署。成本是模块化的,具体取决于您使用的功能。模型训练是在多台服务器上完成的。AWS Sagemaker 缺点:

初级开发人员的学习曲线陡峭。严格的工作流程使得定制变得困难。仅适用于 AWS 生态系统7、MLflow

如果你正在寻找一个开源工具来组织整个机器学习生命周期,那么MLflow可能就是适合你的平台。

MLflow 提供用于管理 ML 流程和部署的解决方案。 它可以进行实验、再现、部署,或者成为中央模型注册表。

该平台可供个人开发人员和团队用于机器学习部署。 它可以合并到任何编程生态系统中。 该库是为了满足各种技术需求而构建的,可以与不同的机器学习库一起使用。

组织整个机器学习生命周期围绕四个主要功能:跟踪、项目、模型和模型注册表。

它有助于简化自动化 ML 模型跟踪的过程。 但它的一个缺点是它无法自动处理模型定义。 这意味着需要手动向模型定义添加额外的工作。

MLflow 的优点:

模型跟踪机制易于设置。它提供了非常直观的 API 服务。日志记录实用且简化,因此很容易进行实验。代码优先的方法。MLflow 缺点:

向模型添加额外的工作并不是自动的。不太容易,但非常适合将模型部署到不同的平台。8、Torchserve

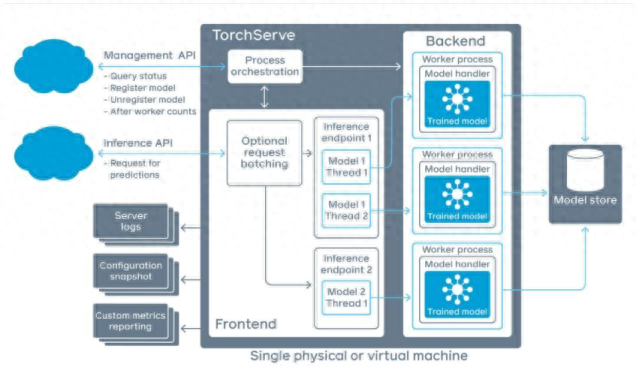

Torchserve 是一个 Pytorch 模型服务框架。 它简化了经过训练的 PyTorch 模型的大规模部署。 它消除了为模型部署编写自定义代码的需要。

Torchserve 由 AWS 设计,作为 PyTorch 项目的一部分提供。 这使得使用 PyTorch 环境构建模型的人可以轻松设置。

它支持低延迟的轻量级服务。 部署的模型具有高性能和广泛的可扩展性。

Torchserve 具有用于某些 ML 任务的内置库,例如对象检测或文本分类。 它可以节省您编写代码的时间。 它提供了强大的功能,例如多模型服务、用于 A/B 测试的模型版本控制、用于监控的指标以及用于应用程序集成的 RESTful 端点。

Torchserve的优点:

简化了部署模型的扩展。服务端点是轻量级的,具有高性能规模。Torchserve缺点:

由于该工具是实验性的,因此经常会发生更改和更新。仅适用于 PyTorch 模型原文链接:http://www.bimant.com/blog/top8-ml-model-deployment-tools/

大家都在看

-

尼康相机创造过哪些“世界之最”?——众通社影像 【众通社影像按】第一、第一台最 “长寿” 的相机系统:F 卡口(64 年不退役)1959 年,尼康 F 卡口随初代单反 Nikon F 诞生,其内径 44mm、法兰距 46.5mm 的规格,在当时被视为 “过度设计”。但正是这份前瞻性,让 ... 机械之最03-23

-

各类轴体,75~98键,哪种机械键盘更适合你?自用百元键盘推荐 本内容来源于@什么值得买APP,观点仅代表作者本人 |作者:亦心之心我大概是从2023年开始,入了机械键盘的坑。零零总总入了不少机械键盘。这些键盘有些是三模的,有些是单模的,不同的轴体,不同的灯光效果,不同的 ... 机械之最03-22

-

哪个品牌机械手表最耐用 手表耐用与否跟手表的功能和手表佩戴人有关,再坚固的手表,像我之前写的一篇文章介绍的暴发户一样,把劳力士放火锅煮,也是不耐用的,所以不能笼统说哪个品牌耐用不耐用,但从总体上分析,以下这些是耐用的机械手表 ... 机械之最03-18

-

机械之美,齿轮运转,动力无限! 发明差速器的人真是太伟大了,因为没有差速器,所有的汽车将无法实现安全的转弯。当汽车转弯时,内侧车轮路径比外侧车轮路径短,因此外侧车轮必须在相同的时间内走比内侧车轮更长的距离,这意味着外侧车轮需要转的更 ... 机械之最03-13

-

标题:《探秘世界“巨无霸机械”:工业奇迹的力量与震撼》 正文:在人类科技发展的长河中,那些体型巨大、功能强大的“巨无霸机械”宛如工业文明的璀璨明珠,它们以令人惊叹的规模和卓越的性能,改变着我们的世界。今天,就让我们一同走进这些机械巨兽的世界,感受它们带来的 ... 机械之最03-13

-

学机械,这9所大学重点考虑! 机械工程专业涵盖机械设计、制造、自动化等领域,培养具备创新思维与实践能力的高素质人才,为现代工业发展奠定坚实基础。机械类专业被誉为国民经济的“装备部”,是我国高校开设最久的专业之一。什么样的学生适合学 ... 机械之最03-13

-

机械魅力:解锁机械结构设计的艺术之美✨ 【设计之美,匠心独运】探索机械结构设计的美学边界,每一幅线稿都是工程师与艺术家的灵魂碰撞。从精密的齿轮咬合到流畅的连杆运动,线条间流露出严谨与灵动的完美融合。本篇带你领略那些隐藏在日常背后的机械之美, ... 机械之最03-06

-

钢铁丛林中的机械美学狂想曲 一、凡尔赛阴影下的 "烟雾弹革命""当理性被战争吞噬,疯狂便会开出最妖异的机械之花。"—— 军事史学家保罗・约翰逊1920 年代的德国正承受《凡尔赛条约》的枷锁,却在火箭炮领域开辟出一条独特道路 ... 机械之最03-04

-

机械专业最具潜力的六个岗位,前景好,薪资高 1. 智能装备研发工程师(就业竞争力TOP1)智能制造浪潮推动下,智能产线设计与工业机器人系统集成岗位需求激增。海尔智家2023年研发投入超120亿元,招聘需求同比增长35%,具备PLC编程与数字孪生技术能力者起薪可达18 ... 机械之最03-04

相关文章

- 为啥好多网友说乾隆就是一台冰冷的政治机器?网友回答道出真相

- 祖冲之:古代中国的数学巨匠与科学先驱

- “机械,最好找工作的专业之一”,山东二本,4个机械男,毕业8年

- 太重1300吨桥式起重机荣获2024年重型机械世界之最科技成果

- 又一项世界之最→太重集团1300t桥式起重机

- 又一殊荣 太重1300t桥式起重机荣获2024年重型机械世界之最科技成果

- 全省唯一!“洛阳制造”再添世界之最

- 经开快讯丨中国重型院项目荣获2024年重型机械世界之最科技成果

- 经开区企业快讯丨中国重型院项目荣获2024年重型机械世界之最科技成果

- 中信再添一“世界之最”中国造“世界最大球团回转窑”获官方认定

- 英国工程师:中国最让我“心塞”的,就是把顶尖机械卖成白菜价!

- 闻香识豆:科学如何赋予罗布斯塔咖啡豆新魅力

- 大国重器,3款世界最大机械,中国制造不输德国

- 盘点工程机械创造的,十大世界吉尼斯纪录!

- 中国农机化之最(四)

- 中国农机化之最(五)

- 机械键盘什么轴最好用?这篇文章告诉你

- 机械类最吃香的十大专业,未来绝对可以和计算机相抗衡的王牌

- 中国农机化之最(二)

- 中国农机化之最(一)