刷屏WAIC,加速生成式AI落地终端,高通亮出诸多“黑科技”

智东西

作者 | 云鹏

编辑 | 漠影

今年科技圈最火热的话题,非生成式AI莫属,而生成式AI发展迭代的速度之快,也令人惊叹。

从GPT-3.5到GPT-4.0,从多模态交互融入到插件的支持,而曾经只能跑在云端的AI大模型,也开始在智能终端设备中落地。

没错,今天拥有数十亿、上百亿参数的AI大模型已经可以直接在你的手机上运行了。注意,是完全本地化运行,只依赖手机本身的算力。

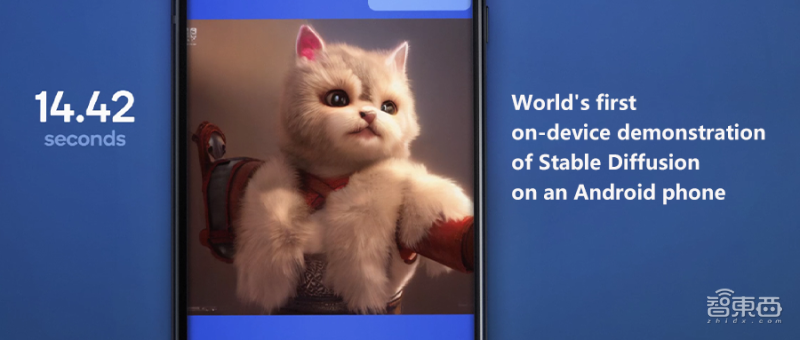

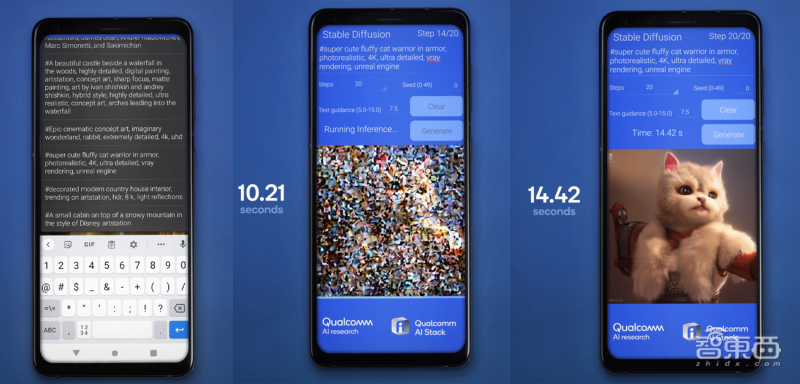

这听起来似乎还有些遥远,但就在上周召开的上海WAIC上,我们已经看到搭载高通第二代骁龙8芯片的安卓手机直接运行参数规模超过10亿的Stable Diffusion,且只需要15秒左右就可以出图,而参数规模超过15亿的ControlNet也成功在手机终端上实现了本地化运行。

搭载骁龙芯片的手机运行Stable Diffusion,15秒左右出图,来源:高通

在WAIC上,我们还能看到各类生成式AI应用已经可以被越来越多的普通消费者通过身边的智能设备接触到。

AI正迎来大爆发时期,就像此前电视、互联网和智能手机的问世,而这种爆发对算力以及计算架构都提出了新的需求。AI训练和推理的成本显著提升,计算架构需要不断演进并满足生成式AI日益增长的处理和性能需求。

在移动芯片巨头高通看来,未来生成式AI的发展必然会是云端与终端侧的“混合”模式。

在这样的大背景下,以智能手机为代表的各类智能终端产品很快就会迎来AI体验的变革,生成式AI无疑将席卷整个智能硬件赛道。

如何实现大模型在端侧的落地?如何实现端侧和云端的高效协同?如何设计出更高效的“混合AI”架构?面向生成式AI革新终端体验的大趋势,从芯片到软件到算法再到生态,高通已经提前布局,成为端侧AI体验变革的核心推动者之一。面向生成式AI的未来,高通已经提前给出了自己的答案。

一、“混合AI”未来已至,手机跑大模型成为现实

生成式AI在终端侧的落地,与我们每一个人的生活密切相关,一项技术从实验室中走到商用,再到面向消费市场大范围落地,必然需要有一个落地的平台,各类智能终端设备无疑扮演着这样的角色。

从去年底到今年年中,短短不到一年,生成式AI及相关产品应用如雨后春笋般成长。据统计,目前已有3000多个可用的生成式AI应用和特性出现。

但这些应用受限于背后大模型的复杂度和庞大规模,绝大部分都只能在云端运行,前不久ChatGPT推出了iOS版本,但该应用的任务处理仍然是基于云端的。

究其原因,AI大模型的推理成本会随着日活用户数量及其使用频率的增长而显著增加。云端推理的高成本,让生成式AI的规模化扩展陷入瓶颈。

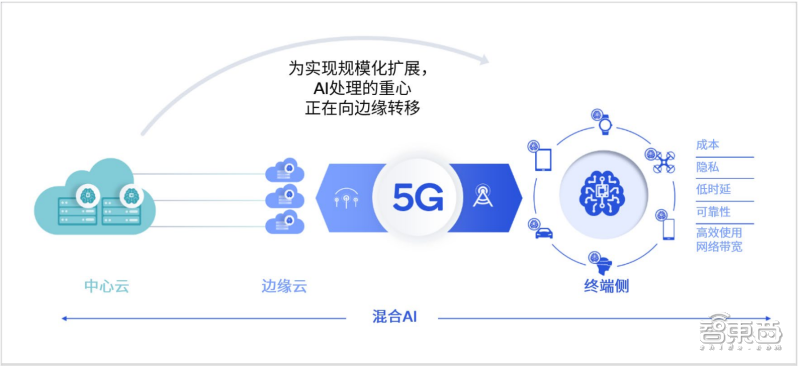

在这样的大趋势下,高通日前发布了《混合AI是AI的未来》技术白皮书,提出了混合AI架构的概念。“混合”,就意味着云端要和手机、PC、XR头显、汽车这些终端设备协同工作,而不是单打独斗。

在今年WAIC上,高通公司高级副总裁兼AI负责人Ziad Asghar就提到,为实现生成式AI的规模化扩展,AI处理的重心正在向边缘转移。

高通技术公司产品管理高级副总裁兼AI负责人Ziad-Asghar,来源:高通

因此AI能否真正在终端侧应用落地,并与云端进行高效协同,就显得至关重要。

从此次WAIC上的一系列演示和获奖成果来看,高通在AI落地智能终端方面显然是走得更快的一家科技巨头,尤其是在其强项的智能手机赛道中,高通已经展示了多个“全球首次”。

可以说,手机跑大模型,已经逐渐走入现实。

Stable Diffusion是我们很熟悉的一个文本到图像生成式AI模型,其参数超过10亿,而在WAIC上,一部搭载高通第二代骁龙8移动平台的智能手机已经可以直接本地运行Stable Diffusion,并且在15秒内生成一张512×512像素的图像。

从现场实际演示来看,其时延已经可以做到和云端相当,且由于是完全本地化运行,用户输入的文本也完全不受限制。

据了解,这背后,高通采用了全栈AI优化的方式,通过量化、编译和硬件加速进行优化,最终实现了这一用例。值得一提的是,高通已经这一能力扩展到了搭载骁龙芯片的PC产品上。

除此之外,高通还演示了ControlNet这一图像到图像生成式AI模型在智能手机上的运行,该模型的参数量更是达到了15亿。

在演示中,ControlNet通过跨模型架构、AI软件和神经网络硬件加速器的全栈式AI优化,在12秒的时间内完成了16步推理,最终完成了AI图像生成,整个过程不需要访问任何云端。

在手机上本地化运行15亿参数的图像到图像模型ControlNet,来源:高通

一方面,高通在WAIC上的展示让我们看到生成式AI落地终端,已经成为现实,另一方面,我们也能看到高通在终端AI领域的实力。因为目前高通是全球唯一一个能够实现在智能手机本地运行大模型的厂商。

高通Ziad Asghar在大会上还做了进一步展望,他说,未来拥有100亿或更大规模参数的生成式AI模型也会在终端上运行,推动生成式AI的普及。

二、背靠数十亿终端,从软硬件到生态,构建全栈式AI能力

WAIC上的一系列成果,让我们看到了高通在终端AI领域已经走在了行业前列,而在这背后,高通已经在终端AI相关硬件、软件、生态等方面储备了诸多产品和技术,形成了自己的全栈式AI能力,这也是高通在AI时代核心的秘密武器之一。

在前文提到的各种智能手机运行AI大模型的案例中,我们经常看到“全栈式AI”这个词,高通的这项能力也是其对于AI产业的核心价值所在。

首先在硬件层面,芯片层的AI运算处理能力是AI落地终端的必要条件,目前高通AI引擎是高通在硬件领域的杀手锏之一。

就在此次WAIC上,第二代骁龙8移动平台中的高通AI引擎获得了2023世界人工智能大会SAIL奖(卓越人工智能引领者奖),这也侧面证明了高通在AI硬件技术方面的能力。

第二代骁龙8移动平台的高通AI引擎荣获SAIL奖,来源:高通

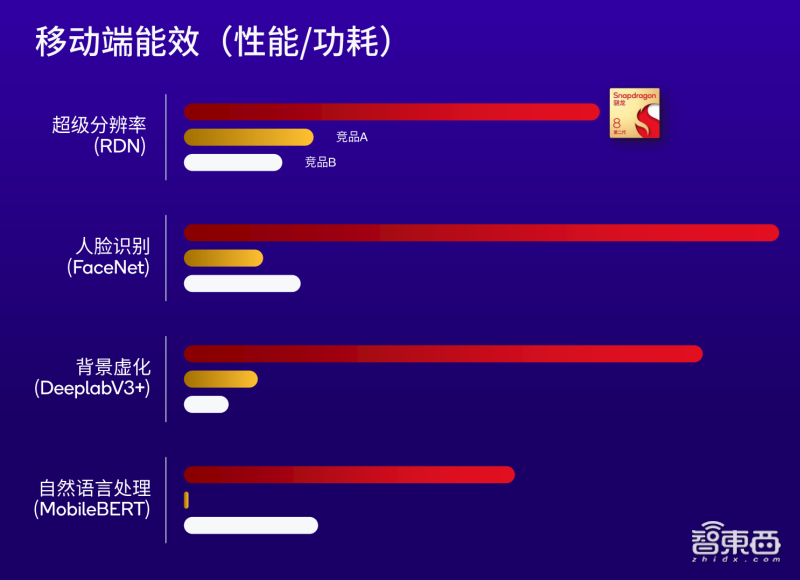

根据高通官方实验数据,搭载高通AI引擎的智能手机,其解决方案的能效与竞品相比大约有2倍左右的优势,以更低功耗提供过硬的终端侧AI性能是高通AI引擎的一大强项。

第二代骁龙8的AI能效与竞品相比较,来源:高通

具体来看,高通AI引擎采用了异构计算架构,其中的Hexagon处理器、Adreno GPU和Kryo CPU这三个模块都对终端侧运行AI应用进行了针对性优化。

Hexagon处理器使用了专用的供电系统,按照工作负载适配功率,从而提升系统能效比。此外,Hexagon处理器支持微切片推理和INT4硬件加速,可以在AI处理方面实现更高性能、更低的能耗和内存占用。

目前生成式AI领域大量应用到Transformer模型,而Hexagon处理器可以对Transformer进行加速,提升生成式AI中一些关键机制的推理速度,根据高通实验数据,在使用MobileBERT的特定用例中,AI性能可以提升4.35倍。

正如前文所说,既然是“全栈”,就要软硬技术都过关。

在软件能力方面,高通AI软件栈可以说是高通所有相关AI软件产品的“集大成”方案, 借助高通AI软件栈,开发者只需要创建一次AI模型,就可以实现跨不同产品的部署。

高通AI软件栈,来源:高通

此外,高通AI软件栈支持TensorFlow、PyTorch、ONNX和Keras等主流AI框架以及对应的runtime,集成了面向Android、Linux和Windows不同版本的高通神经网络处理SDK。

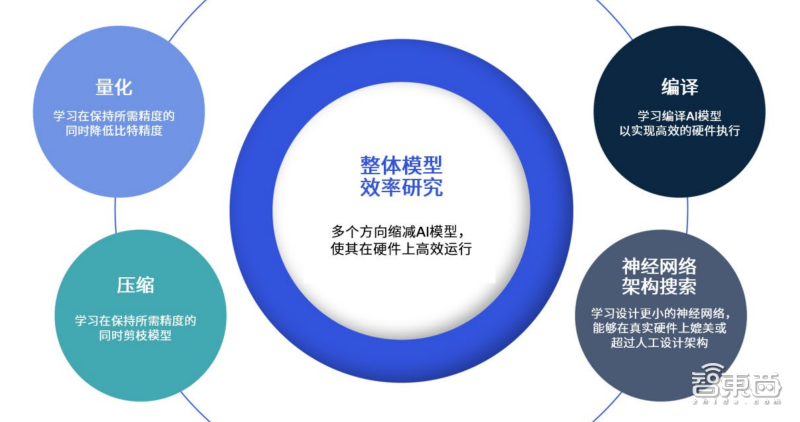

值得注意的是,高通一直专注于AI模型效率研究,从而提升AI模型运行的能效和性能,这对于生成式AI的应用和扩展是至关重要的。

高通通过量化、压缩、条件计算、神经网络架构搜索和编译,在不牺牲太多精度的前提下对AI模型进行了缩减。在量化方面,高通将FP32模型量化压缩到INT4模型,实现了64倍内存和计算能效提升。

在生成式AI领域,像常见的GPT、Bloom以及LLaMA这样基于Transformer的大语言模型通常会受到内存的限制,根据高通实验数据,借助量化感知训练以及更加深入的量化研究,不少生成式 AI 模型可以量化至INT4模型,与INT8相比,性能提升约为90%,能效提升在60%左右。

我们表面上看到的是数十亿参数的大模型轻松地跑在了手机上,但实际上这背后高通在提升AI模型效率方面的研究发挥着关键作用。

高通全球副总裁兼高通AI研究负责人侯纪磊博士在WAIC上特别提到,能效是高通AI解决方案的核心优势之一,以极低功耗提供出色的终端侧AI性能,赋能AI用例,是他们要做的。

高通技术公司全球副总裁兼高通AI研究负责人侯纪磊博士,来源:高通

最后,在硬件、软件之外,高通在全球化规模以及生态建设方面的优势也成为其推动生成式AI落地终端的关键动力。

目前搭载高通AI引擎产品出货量已经超过20亿个,根据市研机构Counterpoint数据统计,搭载骁龙和高通平台的已上市用户终端数量规模在数十亿台。市研机构TechInsights预测,未来高通会以超过40%的市场份额保持AI智能手机处理器出货量第一,超过苹果公司的25%以及联发科的24%。

此外,搭载骁龙平台的已发布XR终端已经超过65款,其中Meta、PICO等头部厂商的旗舰产品均采用的是高通芯片。

可以看到,高通的AI能力已经深入数十亿边缘终端设备,形成跨智能手机、汽车、XR、PC以及企业级AI等现有市场和新兴领域的终端AI生态系统。

凭借在软硬件技术实力、全球化规模和生态系统赋能方面的优势,高通正在推动生成式AI加速落地终端。

正如侯纪磊博士在WAIC上所说到的,凭借一系列基础研究,以及跨AI应用、模型、硬件与软件的全栈终端侧AI优化,高通一直处于终端侧AI解决方案的前沿。

三、深耕AI研究十五年,推动技术从实验室走到消费者手中

科技产业发展的每个时代,都有行业的引领者,通过技术创新带动行业的发展,例如PC时代的微软、英特尔、智能手机时代的苹果,而在生成式AI的新浪潮中,各路玩家仍在寻找自己的定位,产业格局仍充满变量。

能够把握住生成式AI的浪潮,精准利用优势产品和技术切入赛道,对于每家科技公司来说都不是一件容易的事。在WAIC展示的各类生成式AI落地智能手机的用例背后,高通其实在AI前沿技术研究领域已经深耕多年,甚至在生成式AI领域,也已提前多年进行了前瞻性探索。这些研究对于推动AI与移动通信产业的融合发展发挥着关键作用。

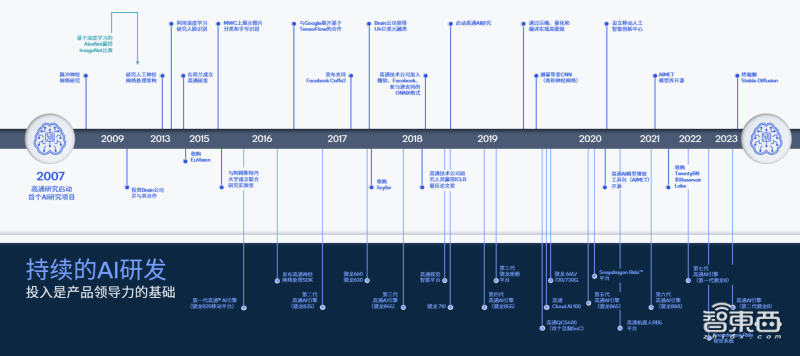

从2007年高通骁龙平台搭载首个Hexagon处理器至今,高通深耕AI研发已超过15年。

高通近15年来AI研究重要节点,来源:高通

从2015年的骁龙820集成了首个专门面向移动平台的高通AI引擎,到2019年骁龙865开始扩展终端侧AI用例,多年来高通一直在推动终端侧AI技术的迭代,让感知、推理和行为等核心能力在终端上落地。

此外,多年来高通的重要AI研究也在影响着行业,推动高能效AI的研究和发展,加速AI在终端侧的落地应用。

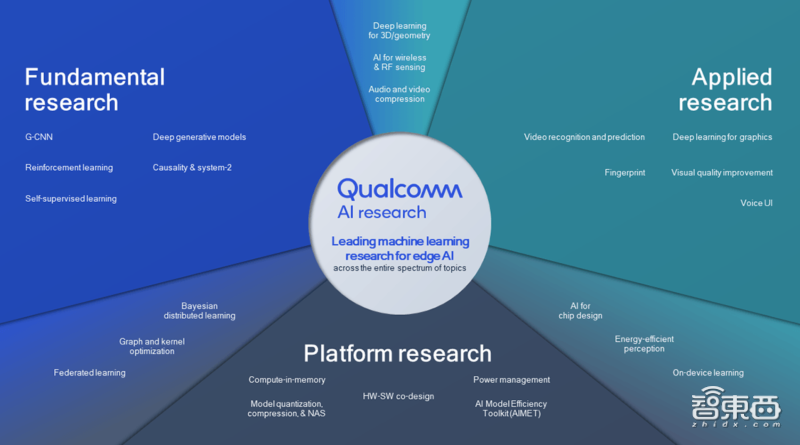

从高通历年发布的AI研究论文来看,高通在计算机视觉、无线和射频传感、能源效率、机器学习、音视频和语言处理、数据压缩模型生成、个性化与联邦学习、强化学习、AI编译器和算法等AI前沿基础理论研究领域均有不少研究成果发布。

高通AI研究主要涉及领域,来源:高通

比如在今年的CVPR上,高通展示了全球首个在移动设备上通过神经编解码器对1080P视频进行编码和解码的演示。根据实际演示视频,在搭载高通芯片的智能手机上,神经编解码器进行视频解码的速度已经达到了35FPS左右。

在手机上进行的1080P神经网络视频编码,来源:高通

与此同时,高通在前沿算法和模型开发领域一直持续迭代自己的技术,比如具备自主学习能力的FrameExit模型、应用在移动终端上的量化技术和创新的编译器栈等。

高通利用INT4模型在终端侧实现了全球首个实时超级分辨率任务处理,与INT8相比,INT4模型的性能和能效提高了1.5倍到2倍。

可以说,十五年来高通在AI领域的深厚积累,已经成为今天他们发力生成式AI、推进混合AI发展的关键技术底蕴。

高通的身影一直活跃在AI技术前沿研究领域,一面连接学术界、产业界,推动着技术的发展,一面连接消费者,完善技术落地产品的体验,高通无疑已经成为“混合AI时代”加速生成式AI落地终端的核心推动者。

结语:生成式AI加速落地终端,AI产业涌现新变量

今天,生成式AI对各行各业产生深刻影响,几乎所有科技公司,都已卷入生成式AI的浪潮。

终端AI应用的深度广度都在加速扩张,云端和终端协同工作的混合AI将成为生成式AI体验的底层保障。百亿甚至千亿规模参数大模型落地终端,也将在不久的将来成为现实。

在未来端云结合的混合AI时代,能够提供全套解决方案的玩家必然会成为产业关注的焦点, 作为底层技术和生态构建者的高通,正成为产业中不可或缺的一环。端侧AI的应用正在迎来一次“进化”,而高通正在为这次革命按下加速键。

大家都在看

-

别再说热带无强国,南美洲坐拥48项世界之最 我们将目光锁定在南美洲,从地理奇观、资源宝藏、农业资源、自然与生态、能源、历史文明、工程奇迹、社会进步、文娱与体育、科技之光等10个不同角度入手,盘点南美洲的世界之最,详情如下。一、地理奇观1.亚马逊河: ... 科技之最04-19

-

怀柔科学城:从实验室到红毯,科学星光永不落幕! 镁光灯下,红毯之上当怀柔科学城的科学家们即将第五次亮相北京国际电影节时也许你会好奇:这座“科技之城”为何能持续“跨界破圈”?怀柔科学城的科学家们已连续多年受邀参加北京国际电影节开幕红毯仪式TA是“硬核实 ... 科技之最04-17

-

自然界最坚硬的东西是金刚石:深入了解金刚石的形成、特性与应用 金刚石,作为自然界中最坚硬的物质之一,常常被用来象征坚韧与永恒。无论是在珠宝界的璀璨光芒,还是在工业界的强大切削能力,金刚石都展现出了其独特的魅力与价值。本文将深入探讨金刚石的形成、物理特性、用途以及 ... 科技之最04-16

-

南京建邺:万亿级新赛道 总部产业基地落地生态科技岛 近日,南京康海无人科技有限公司与中新南京生态科技岛签约,康海智能无人系统产业基地项目正式落地。南京蓝舰智航海上无人系统项目、南京华昇智航空中无人系统项目同步落户生态科技岛。作为新苏合作的重要成果,生态 ... 科技之最04-16

-

全国五大“国家科学中心”开建4年了,现在发展的怎么样了? 当下高速发展的时代,科技创新日新月异,以人工智能、大数据、5G 技术等代表的新技术加速迭代,科技创新无疑是推动社会进步的重要引擎,也已然成为我国统筹安全与发展的关键因素,是构建新发展格局、赢得国际竞争主 ... 科技之最04-09

-

阿基米德:古代科学的巨人,如何改变了我们的世界 在古代希腊的阳光下,有一位伟大的科学家、数学家和工程师,他的名字是阿基米德。作为历史上最杰出的科学家之一,阿基米德的贡献不仅影响了他的时代,更为后世的科学发展奠定了基础。今天,让我们一起走进阿基米德的 ... 科技之最04-05

-

人物传记系列之——郭永怀:以生命铸就的科技丰碑 序章:星陨长空,精神永驻1968年12月5日凌晨,北京西郊机场的玉米地里,一架坠毁的伊尔-14飞机残骸中,两具焦黑的遗体紧紧相拥。当救援人员奋力分开他们的身躯时,一个保存完好的公文包赫然呈现——里面装着中国第一 ... 科技之最04-04

-

如何跨越“死亡谷”?专家共论科技成果转化破局之道 科学家创业成与败的奥秘、硬科技成果转化如何越过死亡之谷、我国产业人才培养存在哪些短板……在2025中关村论坛年会期间,来自高校院所、医疗卫生机构、研究机构、专业服务机构及创新企业的顶尖“大脑”们齐聚中关村 ... 科技之最04-01

-

可控核聚变+深海科技,最核心的6家(建议收藏) 可控核聚变搭配深海科技,最关键的6家企业(建议收藏)可控核聚变与深海科技,核心的6家企业在此(建议收藏)可控核聚变及深海科技,必知的6家核心企业(建议收藏)可控核聚变和深海科技,最值得关注的6家企业(建议 ... 科技之最03-31

-

中国的最尖端科技是什么 中国当前最尖端科技涵盖多个领域,要说尖端好多科技都是引领全球的。中国敢说第二那世界上还真没有哪个国家敢说自己是第一,就比如我国的激光技术,超强超短激光:上海张江实验装置实现10拍瓦激光脉冲输出(1拍瓦=1 ... 科技之最03-27

相关文章

- 感受生命科学“最”新成果的震撼

- 科技之光:照亮未来的璀璨星辰

- 中国的最尖端科技是什么

- “最先进的”与“最基本的”(人民论坛)

- 茶叶中的科学:2025年最值得收藏的春茶科普指南

- 人民论坛:“最先进的”与“最基本的”

- 黄仁勋:华为是中国最强大的科技公司!美国对华为遏制 “糟透了”

- 德媒:杭州致力于成为下一个“科技之都”

- 世界上令人震惊的黑科技有哪些?这10项颠覆你的认知!

- 又一世界之最诞生!细数子午工程二期里的电子科技

- 艾萨克·牛顿:科学革命的巨人

- 又一世界之最诞生!子午工程二期通过国家验收

- 体验海尔AWE,科技是最好的网红

- 史蒂芬霍金宇宙间最闪耀的科学之星

- 可视科学:用可视化技术诠释科学之美

- 人民日报任平文章:弄潮儿向涛头立 科技创新的中国答卷

- 关中平原种粮科技感“拉满”

- 中国最赚钱的科技公司大揭秘:谁才是真正的吸金巨兽?

- 阿基米德:古希腊的“科学魔术师”,他的智慧比星辰更璀璨!

- 震撼!这些前沿科技,正悄悄重塑人类未来

热门阅读

-

万事胜意不能乱说的原因?告诉你万事胜意该对谁说 12-09

-

科威特第纳尔为什么那么值钱?比美元值钱的货币盘点 12-22

-

撕心裂肺十大催泪情歌,10首哭到崩溃的歌曲 12-24

-

不敢公布马航真实原因,内幕曝光简直太惊人! 12-25

-

陈百强什么原因怎么走的,陈百强85事件是什么 01-05

-

麻将公式一定要背下来,麻将手气背转运小妙招 01-19