比GPT-4快18倍,世界最快大模型Groq登场!每秒500

在当今这个信息爆炸的时代,人工智能的发展速度远超我们的想象。最近,一个名为Groq的模型以其惊人的速度,每秒生成近500个token,引起了广泛的关注。这一成就背后的功臣是Groq公司自研的语言处理单元——LPU(Language Processing Unit),这一技术的突破不仅仅是数字游戏,它代表着AI领域的一个重大进步,可能会重新定义我们对效率和性能的认知。

在讨论Groq的技术之前,让我们先来回顾一下传统的AI计算模型。传统上,AI模型的计算依赖于GPU(图形处理单元),其设计初衷是为了处理图形和视频渲染任务。随着AI技术的发展,GPU因其强大的并行处理能力而被广泛应用于机器学习任务中。然而,GPU的设计并非专门针对AI计算,这在一定程度上限制了AI模型的性能提升。

Groq的LPU技术正是为了解决这一问题而生。与GPU相比,LPU采用了时序指令集计算机架构,这意味着它可以更高效地处理AI计算任务,无需频繁地从内存中加载数据。这种设计不仅有助于避免高带宽存储器(HBM)短缺的问题,还能有效降低成本。更重要的是,LPU的每个时钟周期都被有效利用,保证了稳定的延迟和吞吐量,这在执行推理任务时尤为关键。

Groq模型的出现,是基于LPU技术的一次实际应用。其每秒产生近500个token的能力,不仅大大超过了当前主流的AI模型,如ChatGPT-3.5的每秒40个token,甚至在面对更复杂的任务时,其性能也远超GPT-4和Gemini。这种速度的提升,不仅仅是数字上的跳跃,更重要的是它为AI领域带来的可能性。

以代码调试为例,Groq模型能够在极短的时间内完成任务,且在输出速度上比Gemini快10倍,比GPT-4快18倍。这种性能的提升,对于开发者而言意味着更高的工作效率,对于企业而言,则可能意味着更低的运营成本和更快的市场响应速度。

Groq模型的快速响应能力,不仅限于代码调试等特定任务,其在多个领域都有广泛的应用前景。例如,在自然语言处理(NLP)任务中,Groq模型的高速度能够实时生成复杂的文本,极大地提升了交互式AI系统的用户体验。此外,对于需要处理大量数据的科学研究,Groq模型的高效率同样能够大幅缩短研究周期,加快科学进步的步伐。

更值得一提的是,Groq公司提供了两种可以自选的模型,并向开发者免费提供100万token的试用,这一开放策略极大地降低了技术门槛,为更多的开发者和企业提供了接触和应用最前沿AI技术的机会。

Groq的成功不仅展示了LPU技术在AI计算领域的强大潜力,更重要的是,它为整个AI领域提供了新的发展方向。随着LPU技术的成熟和普及,我们有理由相信,未来的AI模型将不再受限于传统计算模型的束缚,其性能和效率将得到前所未有的提升。

此外,Groq模型的出现也促使我们思考AI技术发展的未来趋势。随着技术的进步,AI的应用将更加广泛,其对社会的影响也将更加深远。在这一过程中,如何平衡技术发展与伦理道德的关系,如何确保技术的公平性和可访问性,都是我们需要认真考虑的问题。

总之,Groq模型及其背后的LPU技术,不仅仅是AI领域的一次技术革新,更是对未来技术发展方向的一次探索和预示。随着技术的不断进步和应用的不断拓展,我们有理由期待,未来的人工智能将更加智能、高效,为人类社会带来更多的可能性。

大家都在看

-

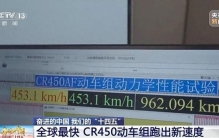

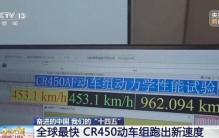

“全球最快高铁”如何炼成 本报记者 李迅典正在试验中的CR450动车组 (铁科院铁道科技影视中心摄影)跑出单列时速453公里、相对交会时速896公里最新纪录的CR450动车组,正在进行运营前的“毕业考试”——60万公里运用考核。这款被视为“十四五 ... 世界最快12-06

-

“全球最快高铁”要来了! 被称作“全球最快高铁”的CR450动车组正在沪渝蓉高铁开展运用考核2021年,“十四五”规划102项重大项目之一的CR450科技创新工程启动。去年年底,CR450动车组样车发布,目前已完成在不同速度、不同场景中的多项试验。 ... 世界最快10-22

-

“全球最快高铁”,有新消息! 被称作“全球最快高铁”的CR450动车组样车去年底公布后,目前正在不同速度、不同场景中进行多项试验。试验期间,CR450动车组跑出了动车组单列时速453公里、相对交会时速896公里的最新纪录。目前,CR450动车组正在沪 ... 世界最快10-22

-

全球最快动车组,正在“刷里程” 人享其行、物畅其流是我国交通运输业发展的目标。“十四五”期间,我国加速织就交通“经纬网”,已拥有世界最大的高速铁路网、高速公路网和邮政快递网,综合立体交通网总里程已超过600万公里。目前,我国国家综合立 ... 世界最快10-21

-

“全球最快高铁”,有新消息 被称作“全球最快高铁”的CR450动车组样车去年底公布后,目前正在不同速度、不同场景中进行多项试验。试验期间,CR450动车组跑出了动车组单列时速453公里、相对交会时速896公里的最新纪录。目前,CR450动车组正在沪 ... 世界最快10-21

-

时速453公里!“全球最快高铁”正在刷里程,明年全面测试!上海到北京2.5小时? 据央视新闻最新消息:被称作“全球最快高铁”的CR450动车组正在沪渝蓉高铁开展运用考核2021年,“十四五”规划102项重大项目之一的CR450科技创新工程启动,去年年底,CR450动车组样车发布,目前已完成在不同速度、不 ... 世界最快10-21

-

全球最快高铁,有重要进展! 被称作“全球最快高铁”的CR450动车组,已完成在不同速度、不同场景中的多项试验,试验期间,更是跑出了单列时速453公里、相对交会时速896公里的最新纪录。目前,CR450动车组正在沪渝蓉高铁开展运用考核,什么是运用 ... 世界最快10-21

-

“全球最快高铁”,要来了! 被称作“全球最快高铁”的CR450动车组样车去年底公布后,目前正在不同速度、不同场景中进行多项试验。试验期间,CR450动车组跑出了动车组单列时速453公里、相对交会时速896公里的最新纪录。目前,CR450动车组正在沪 ... 世界最快10-21

-

世界最快人力自行车,人躺在里面就能骑,时速高达144公里! 注意看,这难道是一颗"蛋"冲过去了吗?此时它正在公路上快速的飞驰着,镜头拉近一看才知道,实则它是世界上跑的最快的人力自行车。令人感到惊讶的是,它的时速竟然超过了144公里,简直把家用汽车远远的甩在 ... 世界最快10-14

-

关键核心技术全面自主化!我国首列,全球最快! 科技日报记者 宋迎迎9月18日,具有完全自主知识产权的我国首列中国标准智能市域列车在青岛亮相,标志着我国在市域轨道交通装备领域取得重要新突破,系列化中国标准智能市域列车实现示范应用。它的问世,引领我国市域 ... 世界最快09-20

相关文章

- 世界最快人力自行车,人躺在里面就能骑,时速高达144公里!

- 关键核心技术全面自主化!我国首列,全球最快!

- 全球最快!时速400公里高铁列车来了

- 全球最快列车亮相“高铁创新之旅”

- 全球最快!在武汉!

- 全球最快、跑出全新试验速度 中国高铁再次冲上热搜

- 再出手!全球最快高铁成功试跑,北京到上海仅需2.5小时?

- 特稿丨时速400公里!全球最快,惊艳亮相!

- 时速400公里运营!“世界最快高铁”将在成渝间开跑

- 时速400公里!全球最快,惊艳亮相!

- 全球跑得最快的高铁,内部长啥样?一探究竟→

- 亮个相吧,全球跑得最快的高铁!

- 时速400公里!全球最快高铁来了

- 时速650公里!全球最快!

- 全球最快!CR450动车组样车在北京发布

- 10米/秒!全球最快的机器狗正式亮相

- 世界最快中低速磁浮开工建设

- 全球公认最快的燃脂运动,每天20分钟,一周暴瘦一圈!

- 世界上“倒退”最快的国家:从发达国家到一贫如洗,只用5年时间

- 全球最快致死记录之一,79年男孩被太攀蛇咬一口,10分钟人就

热门阅读

-

世界上最快的手指,一秒钟敲击琴键13次 10-12

-

世界上速度最快的火箭车,每小时达到1600公里 04-26

-

世界上飞行最快的鸟,灵活的军舰鸟 04-26